[ad_1]

عادة عندما يمثل ممثلو شركات التكنولوجيا أمام مجلس الشيوخ الأمريكي ، فإنهم يميلون إلى معارضة احتمال التنظيم ، ومقاومة الإيحاء بأن تقنيتهم تلحق الضرر.

وهذا ما جعل هذه اللجنة تستمع منظمة العفو الدولية شيء نادر.

اعترف سام ألتمان ، الرئيس التنفيذي لشركة OpenAI – الشركة التي أنشأت ChatGPT و GPT4 ، أحد أكبر وأقوى أنظمة الذكاء الاصطناعي اللغوية في العالم – يوم الثلاثاء: “إن أسوأ مخاوفي هي أننا … عالم.”

ومضى يقول إن “التدخل التنظيمي من قبل الحكومة سيكون حاسمًا للتخفيف من مخاطر النماذج المتزايدة القوة”.

كان هذا بالطبع موضع ترحيب في آذان الساسة الأمريكيين القلقين.

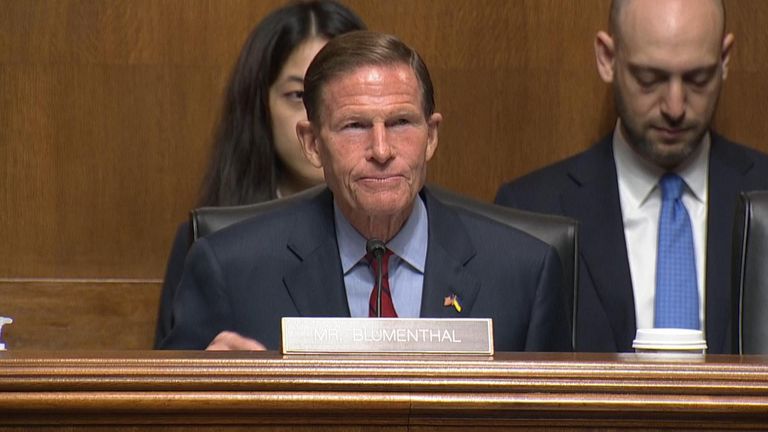

بدأت جلسة الاستماع حول الذكاء الاصطناعي ببيان مسجل مسبقًا من السناتور الديمقراطي ريتشارد بلومنتال يتحدث عن الفوائد المحتملة ولكن أيضًا المخاطر الجسيمة للتكنولوجيا.

لكن لم يكن يتحدث – لقد كان ذكاءً اصطناعيًا تم تدريبه على تسجيلات خطبه ، وقراءة بيان تم إنشاؤه بواسطة GPT4.

من بين تلك الحيل المخيفة للحفلات التي تجعلنا الذكاء الاصطناعي على دراية بها بشكل متزايد.

كان أعضاء مجلس الشيوخ قلقين – ليس فقط بشأن سلامة الأفراد الواقعين تحت رحمة الإعلانات التي يتم إنشاؤها بواسطة الذكاء الاصطناعي ، أو المعلومات المضللة ، أو الاحتيال المباشر – ولكن من أجل الديمقراطية نفسها.

ما الذي يمكن أن تفعله منظمة العفو الدولية ، المدربة على التأثير بعناية في الآراء السياسية لمجموعات الناخبين المستهدفة ، في الانتخابات؟

قال ألتمان من منظمة Open AI إن هذا كان أحد أكبر مخاوفه أيضًا.

في الواقع ، وافق تقريبًا على جميع المخاوف التي عبر عنها أعضاء مجلس الشيوخ.

كانت نقطة الاختلاف الوحيدة لديه أنه كان مقتنعًا بأن الفوائد ستفوق أي مخاطر.

مصدر إلهام غير متوقع للتحكم في الذكاء الاصطناعي

حسنًا ، إذا كانوا جميعًا متفقين ، كيف تنظم الذكاء الاصطناعي؟

كيف ، في الواقع ، هل تكتب قوانين لتقييد تقنية حتى منشئوها الذين لم يفهموا تمامًا بعد؟

إنه سؤال يكافح الاتحاد الأوروبي من أجله الآن بالنظر إلى مقياس متدرج من التنظيم بناءً على مخاطر مكان استخدام الذكاء الاصطناعي.

الرعاية الصحية والخدمات المصرفية ستكون عالية المخاطر ؛ الصناعات الإبداعية ، أقل.

اليوم ، حصلنا على نظرة ثاقبة مثيرة للاهتمام حول كيفية قيام الولايات المتحدة بذلك: ملصقات الطعام.

سأل السناتور بلومنتال ، هل ينبغي فحص نماذج الذكاء الاصطناعي المستقبلية – مهما كان الغرض منها – من قبل مختبرات اختبار مستقلة وتصنيفها وفقًا لمحتواها الغذائي؟

التغذية ، في هذه الحالة ، هي البيانات التي تتغذى بها النماذج.

هل هو نظام غذائي غير مرغوب فيه لجميع المعلومات الموجودة على الإنترنت – مثل GPT4 و Bard AI من Google – التي تم التدريب عليها؟

أم أنها بيانات عالية الجودة من نظام رعاية صحية أو إحصائيات حكومية؟

وما مدى موثوقية نتائج نماذج الذكاء الاصطناعي التي تم تغذيتها بهذه البيانات ، حتى لو كانت عضوية وخالية النطاق؟

اقرأ أكثر:

جيفري هينتون: من هو الأب الروحي للذكاء الاصطناعي؟

رئيس Google ، سوندار بيتشاي ، يعترف بأن مخاطر الذكاء الاصطناعي “ تجعلني مستيقظًا طوال الليل ”

سؤال يلوح في الأفق للثقة في الذكاء الاصطناعي

قال ألتمان إنه يتفق مع فكرة السناتور ويتطلع إلى المستقبل عندما تكون هناك شفافية كافية للجمهور والمنظمين لمعرفة ما بداخل الذكاء الاصطناعي.

لكن هنا يكمن التناقض في دليل ألتمان. والسؤال الذي يلوح في الأفق عندما يتعلق الأمر بتنظيم الذكاء الاصطناعي.

في حين أنه شارك ما هي بلا شك معتقداته الراسخة ، فإن الطريقة التي يتم بها نشر الذكاء الاصطناعي والآخرين في الوقت الحالي لا تعكس ذلك.

تمتلك شركة OpenAI صفقة بمليارات الدولارات مع Microsoft والتي قامت بتضمين GPT4 في محرك البحث Bing الخاص بها لمنافسة شركة Bard AI من Google.

نحن لا نعرف سوى القليل عن كيفية إدارة أنظمة الذكاء الاصطناعي هذه لنظامهم الغذائي للوجبات السريعة أو مدى جدارة قلسهم بالثقة.

هل كان ممثلو هذه الشركات سيتخذون موقفاً مختلفاً من مسألة التنظيم لو كانوا قد جلسوا أمام اللجنة؟

في الوقت الحالي ، تقاوم شركات التكنولوجيا الكبرى الأخرى محاولات تنظيم منتجاتها على وسائل التواصل الاجتماعي.

ميزتهم الرئيسية ، لا سيما في الولايات المتحدة ، هي قوانين التعديل الأول التي تحمي حرية التعبير.

سؤال مثير للاهتمام لخبير دستوري أمريكي هو ما إذا كان للذكاء الاصطناعي الحق في حرية التعبير؟

إذا لم يكن الأمر كذلك ، فهل يقول العديد من صانعي الذكاء الاصطناعي إن اللوائح التنظيمية التي يريدون رؤيتها ستكون أسهل في التنفيذ؟

[ad_2]